گوگل بات (Googlebot) یک خزنده وب است که وظیفه اش جمع آوری اطلاعات صفحات سایت های گوناگون و ارسال آن به سرورهای گوگل جهت آپدیت ایندکس گوگل است. به صورت کلی دو نوع گوگل بات موبایل و گوگل بات دسکتاپ وجود دارند. صرف نظر از موبایل و دسکتاپ، موتور جستجوی گوگل دارای ربات های متعددی است که هر کدام وظیفه خاصی به عهده دارند. به عنوان مثال موتور جستجوی عکس گوگل دارای ربات متفاوت نسبت به موتور جستجوی متن گوگل است.

مراحل کار Googlebot

- ربات گوگل اطلاعات یک صفحه مانند کلمات، کدها، عکسها و منابعی مانند CSS و جاوااسکریپت را جمع آوری میکند.

- اگر لینک یا لینک هایی در صفحات موجود باشد، آنها را در نظر میگیرد.

- کلیه دیتای جمع آوری شده را به سرورهای گوگل ارسال میکند.

برای اینکه گوگل بات بتواند صفحات سایت شما را بخواند به دو نکته مهم توجه داشته باشید:

- اطمینان داشته باشید که گوگل بات می تواند صفحات سایت شما را ببیند.

- گوگل بات باید بتواند به همه منابع صفحات سایت مانند کدهای جاوااسکریپت، CSS و عکسها دسترسی داشته باشد.

انواع Googlebot

گوگل دارای ربات های مختلفی برای اهداف و سرویس های گوناگون است. لفظ Googlebot خطاب به همه ربات های گوگل است، ولی همه ربات های گوگل دارای User agent های اختصاصی نیز هستند که در جدول زیر نام آنها لیست شده است.

| User-agent | کاربرد |

|---|---|

| Googlebot | جستجوی وب |

| Googlebot-News | جستجوی اخبار |

| Googlebot-Image | جستجوی عکس ها |

| Googlebot-Video | جستجوی ویدیو ها |

| AdsBot-Google | بررسی ad quality صفحات وب برای دسکتاپ |

| AdsBot-Google-Mobile | بررسی ad quality صفحات وب برای موبایل |

| Mediapartners-Google | بررسی سایت جهت تعیین نوع محتوا با هدف نمایش تبلیغ مرتبط در سرویس Google Adsense |

| Google-Extended | مورد استفاده در سرویس Bard و Vertex AI گوگل |

| Google-InspectionTool | مربوط به ابزار URL inspection سرچ کنسول |

| DuplexWeb-Google | مربوط به سرویس گوگل داپلکس |

| Google-Safety | برای یافتن malware استفاده می شود و از robots.txt تبعیت نمی کند |

گوگل بات برای Crawl سایت ها از آخرین نسخه Stable مرورگر گوگل کروم استفاده می کند که به آن evergreen Googlebot گفته می شود.

در صورتی که به لاگ وب سرور دسترسی داشته باشید، می توانید با بررسی یوزر ایجنت ها متوجه شوید که چه ربات هایی، کدام صفحات یا منابع را crawl کرده اند.

🔗 منبع: Google Developers

سلام

https://www.google.com/webmasters/tools/googlebot-report

این ابزار گوگل دقیقا برای چی هست و برای پر کردن گزینه هاش چی باید بنویسیم

سلام و وقت بخیر،

در صورتیکه رفتار گوگل بات در سایت شما طبیعی نیست، مثلا تعداد زیادی صفحه را در یک ثانیه کراول می کند، می توانید آن مشکل را توسط این فرم به گوگل ریپورت کنید. برای ارسال گزارش ابتدا باید لاگ سرور را چک کنید که ببینید گوگل بات از چه آی پی در حال کراول صفحه است و آن آی پی را در فیلد اول وارد کنید. سپس چک کنید که گوگل بات با چه user-agent در حال کراول صفحات مورد نظر شما است و آن user-agent را در فیلد دوم وارد کنید. در فیلد سوم هم تعداد بازدید گوگل بات از سایت در روز را وارد کنید و در فیلد Additional details نیز اگر لازم بود، توضیح بیشتری بدهید.

سلام و عرض ادب.

چطور میتونم تنظیماتی انجام بدم تا googlebot صفحاتی که به 404 ارجاع میده رو ایندکس نکنه و نادیده بگیره؟

سلام،

اگر صفحه 404 شما استاندارد باشد و 404 https response در صفحات not found برگرداند، گوگل بات آن صفحات را ایندکس نخواهد کرد.

با سلام

آیا اگر تنظیمات سرچ کنسول را به نحوی انجام دهیم که گوگل بات با سرعت بیشتری صفحات سایت را بخواند، در بهبود سئوی سایت تاثیر دارد؟

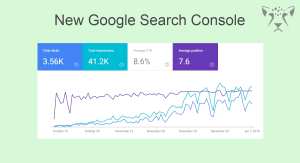

سلام، تنظیم Crawl rate در گوگل سرچ کنسول تاثیری در محاسبات رنکینگ ندارد. اگر گوگل بات با سرعت زیادی صفحات را کراول کند و یا شما در لاگ های سرور ببینید که به عنوان مثال گوگل بات بیشتر از قبل در حال کراول سایت شما است، به معنای بهبود رنکینگ سایت شما نیست.

سلام چطور میشه فهمید که گوگل بات روزانه چند صفحه از سایت ما را کراول می کند؟

سلام، شما می توانید از طریق چک کردن لاگ های سرور متوجه شوید که چه user-agentهایی برای سرور شما request فرستاده اند. با چک کردن لاگ می توانید گوگل بات، بینگ بات و بقیه robotهایی که به سرور شما request ارسال کرده اند را شناسایی کنید.

سلام از کجا بفهمیم که گوگل بت صفحات سایت ما رو میبینند ؟

سلام. شما می توانید از طریق fetch کردن صفحه مورد نظرتان در گوگل سرچ کنسول، چک کنید که آیا گوگل بات به صفحه مورد نظر شما دسترسی دارد یا خیر.

سلام عالی بود

یه سوال هست؟ گوگل بات چطوری متن مطالب رو از سایر متن های سایت تشخیص میده حالا بر فرض مثال گوگل بات این کار رو انجام نمیده و به مرکز میفرسته این کار رو انجام میده الگوریتم تشخیص متن از بین این همه کد و حالا مطالب اصلی هست یا نیست چطوری انجام میشه چطوری میتونم در این مورد مطلبی پیدا کنم.

سلام.همانطور که در متن اشاره شده و خودتان نیز به آن اشاره فرمودید، گوگل بات کد HTML صفحه به همراه منابع را می خواند و به ایندکس گوگل میفرستد. در آنجا نیز الگوریتمهای گوگل از روی کد HTML میتوانند تشخیص دهند که کدام قسمت منو،متن مقاله، هدر، فوتر، عکس، متن یک کامنت و یا دیگر قسمت های یک صفحه است. اصولا الگوریتم های گوگل و دیگر robot ها نیز به همین روش عمل میکنند. ضمنا برای درک بهتر موتورهای جستجو از سایت توصیه می شود که از structured data نیز استفاده شود.

نحوه تشخیص چطوری هست مثلا من بخواهم یه خزنده بنویسم براساس کدهای هر سایت متفاوت هست و نمیشه مطالب رو تشخیص داد مگر اینکه با تفکیک html, سایر موارد را تشخیص بدهم حالا اگر کلی سایت باشه هر سایت ممکنه ساده یا پیچیدگی خاص خودش رو داشته باشه صدرصد یه الگوریتمی داره چون ربات هست و انسان نیست که بتونه مطلب رو تشخیص رو بده و ربات هم با یک سری دستورات اینکار رو انجام میده

در ربات های ساده، برای هر نوع صفحه، الگوریتم مشخصی نوشته می شود ولی نوشتن رباتی مانند گوگل بات که بتواند انواع صفحات را تشخیص دهد، قطعا دانش برنامه نویسی و تجربه بالایی نیاز دارد. برای آموزش نوشتن ربات در گوگل عبارت Web Crawler Tutorial را جستجو کنید.

امان از این خزنده گوگل که همه سایت ها اگه بهترین مطلب رو بنویسند ولی گوگل بت نخونه و کرال نکنه وبمسترش انگار کاری نکرده و حتی همه زحماتی که برای تولید محتوا اصولی کشیده باشه هم به هدر میره.

اینکه Googlebot برای پیدا کردن محتوای سایت ها 10 تا کرالر داره رو نمی دونستم و خیلی برام جالب بود. چرا یک کرالر همه کارها را انجام نمیدهد؟

هر crawler وظیفه مشخصی دارد. به عنوان نمونه، کرالر سرویس تبلیغات گوگل یا همان گوگل ادوردز نباید همه سایت ها را بررسی کنید و فقط باید سایتهایی که از گوگل ادوردز استفاده میکنند را بخواند و بررسی کند. بقیه خزنده ها هم به همین ترتیب رفتار خواهند کرد.

سلام ممنونم بابت توضیح گوگل بت یا کرالر گوگل، خیلی کامل معرفی کرده بودید،یک سئوال داشتم، آیا گوگل بات ها جهت تشخیص فریب سایت که گاهاً برای ایجاد صفحات زیاد از تکنیک های مختلف استفاده میکنند، هوشمند هستند و خود خزنده گوگل به صفحات سایت ها رنک می دهد یا اینکه وظیفه خزشگر گوگل یا Webcrawler فقط پیداکردن محتوا و خواندن صفحات سایت ها هست و امور رنک دهی به صفحات وب سایت ها در ساختار دیگری انجام می گردد؟

کراولر ها فقط صفحات را میخوانند و اطلاعات کامل آنها را به سرورهای گوگل ارسال میکنند و در نهایت ایندکس گوگل آپدیت میشود و در آنجا محاسبات رنکینگ توسط الگوریتمهای گوگل انجام می پذیرد. الگوریتمهای متنوعی مانند مرغ مگس خوار، آپدیت کبوتر گوگل، گوگل رنکبرین، الگوریتم دزد دریایی، آپدیت گوگل پاندا، آپدیت پنگوئن و موبایل گدون وجود دارد که هر کدام محاسبات خاصی را انجام میدهند.